[Statistiques, Psychologie] Les biais

Les biais… les biais, les biais… j’avais mis de coté ce sujet même si j’en ai parlé à de nombreuses fois… vous pouvez cliquer sur les différents liens si vous le voulez :

Je reprends à nouveau des infos sur wikipedia, je vais tenté de fusionner des articles pour comprendre les différents biais d’un point de vue statistique et psychologique.

En statistique ou en épidémiologie, un biais est une démarche ou un procédé qui engendre des erreurs dans les résultats d’une étude.

Formellement, le biais de l’estimateur d’un paramètre est la différence entre la valeur de l’espérance de cet estimateur (qui est une variable aléatoire) et la valeur qu’il est censé estimer (définie et fixe).

Le terme biais fait référence à une déviation systématique de la pensée logique et rationnelle par rapport à la réalité.

Les biais cognitifs conduisent le sujet à accorder des importances différentes à des faits de même nature et peuvent être repérés lorsque des paradoxes ou des erreurs apparaissent dans un raisonnement ou un jugement.

L’étude des biais cognitifs fait l’objet de nombreux travaux en psychologie cognitive, en psychologie sociale et plus généralement dans les sciences cognitives.

Ces travaux ont identifié de nombreux biais cognitifs propres à l’esprit humain à travers de multiples domaines : perception, statistiques, logique, causalité, relations sociales, etc.

Du point de vue de leurs domaines, on peut distinguer entre autres des erreurs de perception, d’évaluation, d’interprétation logique.

Ces biais cognitifs ne sont généralement pas conscients.

Leur caractérisation est importante aussi bien dans les domaines judiciaire que scientifique puisqu’ils sont néfastes dans un processus logique.

La publicité exploite souvent des biais cognitifs pour faire passer ses messages (raisonnement fallacieux, oubli de la fréquence de base).

Certains de ces biais peuvent en fait être efficaces dans un milieu naturel tel que ceux qui ont hébergé l’évolution humaine, permettant une évaluation ou une action plus performante ; tandis qu’ils se révèlent inadaptés à un milieu artificiel moderne.

Définition

Selon Jean-François Le Ny, psychologue spécialisé dans la cognition : « Un biais est une distorsion (déviation systématique par rapport à une norme) que subit une information en entrant dans le système cognitif ou en sortant. Dans le premier cas, le sujet opère une sélection des informations, dans le second, il réalise une sélection des réponses »2

Historique et débats

Le terme de biais cognitif a été introduit au début des années 1970 par les psychologues Daniel Kahneman et Amos Tversky pour expliquer certaines tendances vers des décisions irrationnelles dans le domaine économique.

De nombreux chercheurs ont contribué sur le sujet, avec des avis contradictoires, suscitant débats et polémiques.

La rationalité limitée de l’individu est évoquée du fait des limitations inhérentes au système cognitif dans le traitement des informations, qui conduit à des biais inévitables.

Certains y voient un échec de la rationalité humaine, tandis que pour d’autres, tels que Jonathan St. B. T. Evans, l’existence de ces biais est « en raison plutôt qu’en dépit de la nature de notre intelligence ».

Gerd Gigerenzer, « virulent contradicteur » de Kahneman et Tversky, développe une vision « optimiste » de la question, mettant en évidence les situations courantes qui nécessitent, à propos, des heuristiques de jugement.

Selon Albert Moukheiber, docteur en neurosciences cognitives, les biais cognitifs peuvent être utilisés pour se donner des repères dans la société et justifier nos prises de décisions ; les heuristiques permettent la survie face à un danger imminent.

De fait, dès leurs premières recherches dans les années 1970, Kahneman et Tversky ont proposé une vision nuancée des heuristiques qui bien que menant à des biais, peuvent parfois conduire à des jugements raisonnables.

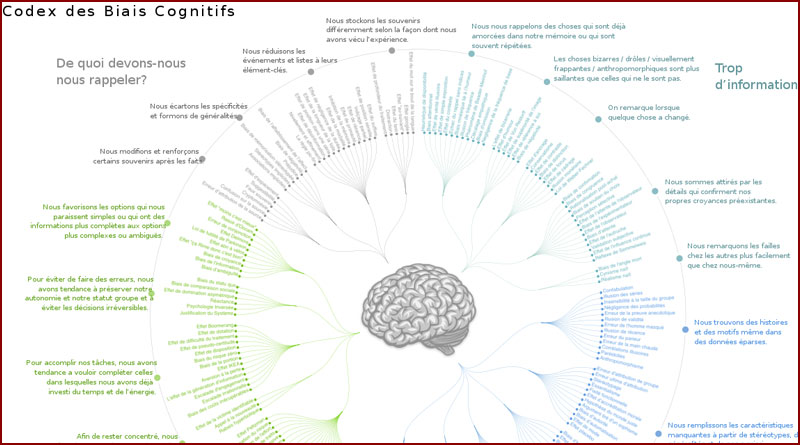

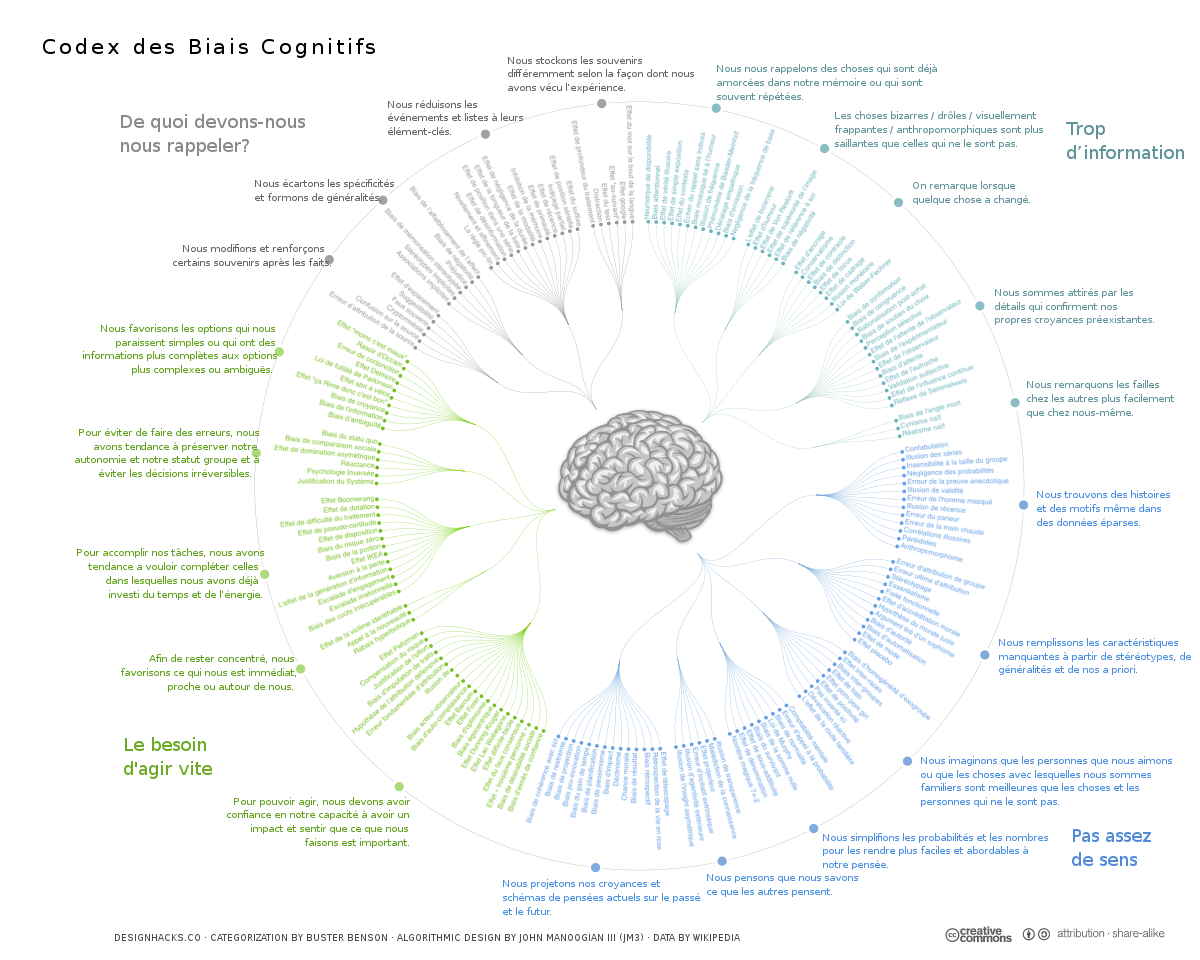

Cliquez pour voir l’image en plus grand

Cliquez pour voir l’image en plus grand

Biais sensori-moteurs

- S’agissant des processus sensori-moteurs, on parle par habitude plutôt d’illusions que de biais.

Biais attentionnels

- Biais d’attention — avoir ses perceptions influencées par ses propres centres d’intérêt.

Biais mnésique

- Effet de récence — mieux se souvenir des dernières informations auxquelles on a été confronté.

- Effet de simple exposition — avoir préalablement été exposé à quelqu’un ou à une situation le/la rend plus positive.

- Effet de primauté — mieux se souvenir des premiers éléments d’une liste mémorisée.

- Oubli de la fréquence de base — oublier de considérer la fréquence de base de l’occurrence d’un événement alors qu’on cherche à en évaluer une probabilité.

Biais de jugement

- Appel à la probabilité — tendance à prendre quelque chose pour vrai parce que cela peut probablement être le cas.

- Aversion à la dépossession — tendance à donner plus de valeur à un bien ou un service lorsque celui-ci est sa propriété.

- Biais d’ancrage — influence laissée par la première impression.

- Biais d’attribution (attribution causale) — façon d’attribuer la responsabilité d’une situation à soi ou aux autres.

- Biais d’auto-complaisance — se croire à l’origine de ses réussites, mais pas de ses échecs.

- Biais d’engagement — tendance à poursuivre l’action engagée malgré la confrontation à des résultats de plus en plus négatifs.

- Biais d’équiprobabilité — tendance à penser qu’en l’absence d’information, des évènements sont équiprobables.

- Biais d’immunité à l’erreur — ne pas voir ses propres erreurs.

- Biais d’intentionnalité — consiste à percevoir l’action d’une volonté ou d’une décision derrière ce qui est fortuit ou accidentel.

- Biais de confirmation — tendance à valider ses opinions auprès des instances qui les confirment, et à rejeter d’emblée les instances qui les réfutent.

- Biais de normalité : tendance à penser que tout va se passer comme d’habitude et à ignorer les signes avant-coureurs

- Biais de présentéisme — privilégier les facteurs présents est plus économique cognitivement à modéliser que les facteurs absents.

- Biais de proportionnalité — favoriser l’idée fausse que si l’on observe une augmentation des manifestations d’un phénomène, c’est que le nombre d’occurrences de ce phénomène croît en effet, sans voir que cette augmentation peut n’être que la conséquence de l’amélioration de l’outil d’observation.

- Biais de statu quo — la nouveauté est vue comme apportant plus de risques que d’avantages possibles et amène une résistance au changement.

- Biais égocentrique — se juger sous un meilleur jour qu’en réalité.

- Biais rétrospectif ou l’effet « je le savais depuis le début » — tendance à juger a posteriori qu’un événement était prévisible.

- Effet d’ambiguité — tendance à éviter les options pour lesquelles on manque d’information.

- Effet de halo — une perception sélective d’informations allant dans le sens d’une première impression que l’on cherche à confirmer.

- Effet de simple exposition — avoir préalablement été exposé à quelqu’un ou à une situation le/la rend plus positive.

- Effet Dunning-Kruger — les moins compétents dans un domaine surestiment leur compétence, alors que les plus compétents ont tendance à sous-estimer leur compétence.

- Effet Ikea — tendance pour les consommateurs à accorder une valeur supérieure aux produits qu’ils ont partiellement créés.

- Effet Stroop — incapacité d’ignorer une information non pertinente.

- Effet râteau — exagérer la régularité du hasard.

- Erreur fondamentale d’attribution (ou biais d’internalité) — accorder plus d’importance aux facteurs internes à l’orateur (intentions, émotions) qu’à son discours ou à ses actes (faits tangibles). Couramment utilisé pour discréditer les éléments rationnels par des éléments émotionnels, qui sont en pratique souvent imaginés et attribués sans preuve à l’orateur puisque ses émotions internes sont difficilement discernables a priori.

- Illusion de savoir — dans une situation en apparence identique à une situation commune, réagir de manière habituelle, sans éprouver le besoin de rechercher les informations complémentaires qui auraient mis en évidence une différence par rapport à la situation habituelle. Il peut ainsi faire état d’une mauvaise croyance face à la réalité.

- Illusion monétaire — confusion d’un agent économique entre variation du niveau général des prix et variation des prix relatifs.

- Illusion de transparence et illusion de connaissance asymétrique.

- Loi de l’instrument (ou marteau de Maslow) — tentation qui consiste à travestir la réalité d’un problème en le transformant en fonction des réponses (les outils) dont on dispose.

- Sophisme génétique — tendance à juger le contenu en fonction du contenant, le message en fonction du messager, le fond suivant la forme.

- Supériorité illusoire — surestimation de ses propres qualités et capacités.

- Tache aveugle à l’égard des préjugés — tendance à ne pas percevoir les biais cognitifs à l’œuvre dans ses propres jugements ou décisions, et ce, aux dépens d’informations plus objectives.

Biais de raisonnement

- Biais de confirmation d’hypothèse — préférer les éléments qui confirment plutôt que ceux qui infirment une hypothèse.

- Biais d’évaluation de probabilités.

- Biais de représentativité — considérer un ou certains éléments comme représentatifs d’une population.

- Biais de disponibilité — ne pas chercher d’autres informations que celles immédiatement disponibles.

- Biais d’appariement — se focaliser sur les éléments contenus dans l’énoncé d’un problème.

- Biais de sélection : les personnes sondées ne sont pas représentatives de la population générale (biais de recrutement, biais par autosélection)

- Biais du survivant — se focaliser sur les éléments ayant passé avec succès un processus de sélection pour en tirer des conclusions sur la totalité des éléments.

- Dissonance cognitive : le refus des réalités pour ne pas remettre en cause des croyances ou des pratiques solidement ancrées.

- Réduction de la dissonance cognitive — réinterpréter une situation pour éliminer les contradictions.

- Effet rebond (assimilable à l’effet Streisand) — une pensée que l’on cherche à inhiber devient plus saillante.

- Illusion des séries — percevoir à tort des coïncidences dans des données au hasard.

- Perception sélective — interpréter de manière sélective des informations en fonction de sa propre expérience.

- Réification du savoir — considérer les connaissances comme des objets immuables et extérieurs.

- Effet de domination asymétrique ou effet leurre — choisir pour un consommateur entre deux options celle qui est la plus proche d’une troisième option malgré la forte asymétrie d’information.

- Coût irrécupérable — considérer les coûts déjà engagés dans une décision.

- Oubli de la fréquence de base — oublier la fréquence de base de l’occurrence d’un événement dont on cherche à évaluer la probabilité.

Biais liés à la personnalité

- Biais d’optimisme — optimisme dispositionnel, optimisme irréaliste, parfois présenté comme un « non-pessimisme dispositionnel » et d’optimisme comparatif qui semble très ancrée chez l’être humain ; il s’agit d’une croyance individuelle qui est que le sujet se juge moins exposé à la plupart des risques qu’autrui. On peut évaluer le degré d’adhésion à cette croyance en demandant au sujet d’évaluer son risque de rencontrer un événement négatif en comparaison à celui d’autrui. Cette croyance aggrave certaines prises de risques et est souvent impliquée dans l’accidentologie routière (le conducteur s’estimant à tort plus habile que les autres pour éviter les accidents, même quand il ne respecte pas le code de la route, en raison d’une surestimation infondée et irréaliste de ses capacités).

- Effet Barnum — accepter une vague description de la personnalité comme s’appliquant spécifiquement à soi-même (ex. : horoscope).

Biais statistiques

- biais effet-centre

- biais de vérification (work-up biais)

- biais d’autosélection, estimé à 27 % des travaux d’écologie entre 1960 et 1984 par le professeur de biologie américain Stuart H. Hurlbert, traitant des pseudoréplications

- biais de mesure : les techniques de mesures sont incorrectes.

- biais de notification

- biais de publication : les données sont davantage diffusées lorsqu’elles arrangent les auteurs de l’étude (voir Biais d’autocomplaisance).

- biais de confirmation

- biais de confusion

- biais d’un estimateur

- biais de suivi (appelé aussi biais de réalisation) : lorsque les deux groupes de patients ne sont pas suivis de la même manière au cours de l’essai.

- biais d’attrition : retrait de certains patients de l’analyse

- biais d’évaluation : lorsque la mesure du critère de jugement n’est pas réalisée de la même manière dans les deux groupes de patients

- biais d’indication : cas particulier de biais de confusion, lorsqu’une intervention est plus souvent prescrite à des sujets à risque élevé

- biais d’information

- biais d’interprétation : erreur dans le mode d’analyse des résultats (biais de confirmation d’hypothèse…)

- biais de spectre : en médecine, un test diagnostique peut offrir une sensibilité variant en fonction de la gravité de la maladie.

- erreur écologique

- problème d’agrégation spatiale

En recherche clinique (médicale), par exemple, ces variables parasites peuvent être : l’évolution spontanée de la maladie, l’effet placebo et de régression à la moyenne.

Éviter les biais de confusion

Pour éviter les biais de confusion, le protocole expérimental idéal consiste à réaliser une étude comparative, randomisée et à double insu.

La comparaison entre deux (ou plusieurs) groupes appariés isole l’effet de la variable indépendante.

La randomisation limite l’effet de variables parasites non contrôlées en assurant la distribution statistique entre les groupes.

La procédure d’insu protège la mesure des résultats des attentes des chercheurs et de la présomption des sujets.

Ce biais se manifeste chez un individu lorsqu’il rassemble des éléments ou se rappelle des informations mémorisées, de manière sélective, les interprétant d’une manière biaisée.

Les biais de confirmation apparaissent notamment autour de questions de nature affective et concernant des opinions ou croyances établies.

Par exemple, pour s’informer d’un sujet controversé, une personne pourra préférer lire des sources qui confirment ou affirment son point de vue.

Elle aura aussi tendance à interpréter des preuves équivoques pour appuyer sa position actuelle.

Les biais dans la recherche, l’interprétation et le rappel de la mémoire ont été invoqués pour expliquer l’attitude de polarisation (quand un désaccord devient plus extrême, même si les différentes parties sont confrontées à la même preuve), de persévérance de conviction (quand la croyance persiste après que les preuves la soutenant sont démontrées fausses), l’effet de primauté irrationnelle (une plus forte importance pour les premières données rencontrées) et l’illusion de corrélation (par laquelle les personnes perçoivent à tort une association entre deux événements ou situations).

Une série d’expériences dans les années 1960 suggère que les individus sont biaisés en faveur de la confirmation de leurs croyances actuelles.

Des travaux ultérieurs ont expliqué ces résultats par une tendance à évaluer les idées d’une manière unilatérale, mettant l’accent sur une possibilité unique et ignorant les alternatives.

En combinaison avec d’autres effets, cette stratégie de pensée peut biaiser les conclusions qui sont atteintes. Pour expliquer les biais observés, on invoque notamment le rôle du désir dans la pensée et les limitations de la capacité humaine au traitement de l’information.

Une autre hypothèse est que les individus montrent un biais de confirmation, car d’une manière pragmatique ils évaluent le coût d’être dans l’erreur, plutôt que d’enquêter d’une manière neutre ou scientifique.

Les biais de confirmation contribuent à l’excès de confiance dans les croyances personnelles et peuvent maintenir ou renforcer les croyances face à des preuves contraires.

Ils peuvent donc conduire à des décisions désastreuses, en particulier dans des contextes organisationnels, militaires, politiques ou sociaux.

Plus d’infos : wikipedia

Ce terme regroupe tous les biais pouvant conduire à ce que les sujets effectivement observés lors d’une enquête ne constituent pas un groupe représentatif des populations censées être étudiées et ne permettent donc pas de répondre aux questions posées dans le protocole.

Les biais de sélection se produisent lors de l’échantillonnage, c’est-à-dire lors de la sélection d’un échantillon représentatif de la population étudiée.

Ils sont liés aux critères d’inclusion des individus dans l’étude et se produisent lorsque les sujets inclus dans l’étude ne constituent pas un groupe représentatif de la population cible.

Cela se produit lorsque les sujets sélectionnés dans l’échantillon ont des caractéristiques qui les distinguent de l’ensemble de la population-mère, ce qui est inévitable puisque ce sont ces caractéristiques qui déterminent l’échantillon de personnes.

Le risque de biais de sélection est faible dans les études expérimentales et longitudinales, élevé dans les études cas-témoins et considérable dans les études transversales.

Dans le domaine de la santé, un biais de sélection aura lieu si après constitution dudit groupe, il y a ce que l’on nomme des « perdues de vues », c’est-à-dire des personnes ayant quitté l’enquête épidémiologique en cours.

Architecture et construction

En architecture également, les bâtiments de plus de cent ans encore debout donnent une fausse impression de « qualité de la construction d’antan » alors qu’ils ne représentent qu’une infime part de ce qui a été construit depuis l’invention de la construction, le reste s’étant écroulé ou ayant été démoli.

Arts

La musique des périodes précédentes est souvent considérée comme meilleure que la musique actuelle.

Cela pourrait être du au fait que seule la meilleure musique des temps passés est toujours jouée et écoutée de nos jours alors que la musique contemporaine, qu’elle soit bonne ou mauvaise, est facilement accessible et diffusée.

Ainsi, seule la survivance des meilleurs musiques des temps passés crée un biais de perception.

Chats

Une étude réalisée en 1987 montre que les chats qui chutent d’une hauteur équivalente à moins de six étages et qui survivent ont des blessures plus graves que les chats tombant d’une hauteur plus élevée.

L’une des hypothèses proposées affirme que cela est causé par la baisse du stress chez l’animal une fois la vitesse terminale atteinte, ce qui l’amène à être plus « mou » lors du choc au sol.

La situation pourrait cependant s’expliquer par un biais des survivants.

Il est beaucoup moins probable que les chats qui meurent à la suite d’une chute soient emmenés chez le vétérinaire par rapport aux chats blessés par une chute.

Les chats morts à la suite d’une chute de plus de six étages sont donc retirés des statistiques, ne laissant la place qu’aux chats « survivants ».

Finance et économie

Dans le domaine de la finance, le biais des survivants survient lors de l’exclusion des entreprises ayant fait faillite des études de performance.

Ainsi, par exemple, si une étude évalue la performance des entreprises pour une certaine période, les entreprises n’ayant pas « survécu » à cette période seront exclues de l’étude.

En 1996, Elton, Gruber et Blake montrent que le biais des survivants est plus étendu dans le domaine des petits fonds mutuels que dans celui des gros, probablement en raison du plus grand nombre de faillites chez les petits.

Militaire

Au cours de la Seconde Guerre mondiale, le statisticien Abraham Wald a pris en compte le biais des survivants dans ses calculs afin d’évaluer comment minimiser la perte de bombardiers sous le feu ennemi.

En étudiant les dommages causés à des aéronefs revenus de mission, l’étude a recommandé de blinder les endroits des appareils qui présentaient le moins de dommages.

En effet, Wald a constaté que les études précédentes ne tenaient compte que des aéronefs qui avaient « survécu » à leur mission, sans tenir compte de ceux qui avaient disparu.

Ainsi, les endroits endommagés des aéronefs revenus représentent les endroits où ces derniers peuvent encaisser des dommages et réussir à rentrer à la base.

La conclusion de Wald est que lorsqu’un aéronef est endommagé à un autre endroit, il ne revient pas de sa mission.

En conséquence, ce sont ces endroits – ceux non endommagés chez les « survivants » – qui devraient être renforcés, et non les endroits endommagés.

Production industrielle

Le biais des survivants entre souvent en cause pour expliquer certains lieux communs (parfois vrais aussi souvent faux) comme « les produits étaient mieux fabriqués avant » car cette assertion se base évidemment sur les objets artisanaux ou manufacturés qui ont survécu et ne tient absolument pas compte de tous ceux qui sont en décharge, à la poubelle ou recyclés depuis longtemps.

Bien que le biais des survivants puisse expliquer une part importante de l’idée commune que les vieux produits étaient plus solides et durables, d’autres effets peuvent entrer en jeu, tels que l’obsolescence programmée ou la suringénierie.

Pour cette raison, il est difficile de réellement comparer deux produits dans le temps, et de déterminer, si globalement, la qualité est meilleure ou non.

Les biens manufacturés évoluent constamment, les procédés industriels, les composants, matières, techniques également.

Pour ces raisons, il est possible de concevoir et produire des produits durables également, mais la pression sur les coûts de production et les délais ont également augmenté, aboutissant à l’apparition de produits plus techniques, mais parfois plus éphémères.

De manière générale, le consommateur a accès à des produits d’une durabilité au moins comparable à celle des produits des générations précédentes.

Encore une fois, le biais des survivants fait que ne sont pris en considération que les produits ayant survécu au temps tandis que la masse d’objets de faible qualité et ayant disparu est ignorée.

Ce biais cognitif a été d’abord défini dans le livre Person Perception de Albert H. Hastorf, David J. Schneider, Judith Polefka en 1970.

Par exemple, un individu justifiera l’obtention d’une bonne note à un examen en évoquant le travail qu’il a fourni, alors qu’il expliquera l’obtention d’une mauvaise note par la sévérité du correcteur.

Un professeur justifiera les bonnes notes de sa classe en évoquant la qualité de ses cours, les mauvaises notes à des élèves qui suivent mal ou apprennent mal le cours.

En 1986, Leary et Shepperd mettent en exergue, à travers leurs recherches sur l’anxiété sociale, le concept de biais d’auto-handicap qu’ils considèrent comme une forme spéciale de biais d’auto-complaisance.

Cette stratégie est préventive.

Les gens anticipent des causes externes ou internes pour expliquer leur échec ou leur réussite afin de maintenir ou de rehausser leur image de compétence.

Des études montreront par la suite l’existence de différences dans l’utilisation de ces stratégies d’un individu à l’autre, notamment entre les femmes et les hommes, et selon que l’individu montre une faible estime de soi ou au contraire une haute estime de soi.

Jean de La Fontaine a mis en évidence ce biais d’autocomplaisance dans l’une de ses fables : L’Ingratitude et l’injustice des Hommes envers la Fortune.

C’est un biais de jugement qui pousse à se fier à l’information reçue en premier dans une prise de décision.

Dans le domaine de la décision, Tversky et Kahneman ont décrit l’heuristique ancrage-ajustement et expliquent certaines erreurs comme étant le résultat d’un ajustement insuffisant.

Dans un article ils expliquent qu’il fut demandé à des groupes de sujets d’estimer certaines quantités en pourcentage, par exemple le pourcentage de pays africains dans les Nations unies.

Pour chaque quantité, un nombre entre 0 et 100% fut déterminé par la rotation d’une roue de la fortune en présence des sujets.

Les sujets durent ensuite indiquer s’ils pensaient que la valeur était supérieure ou inférieure à ce nombre, et ensuite estimer la valeur en partant vers le haut ou vers le bas vis-à-vis de ce nombre.

Les différents groupes de sujets ont chacun reçu des nombres arbitraires différents et différentes quantités à estimer.

Par exemple, l’estimation médiane de pays africains était de 25% par ceux qui ont reçu 10% comme point de départ ; 45% par ceux qui ont reçu 65% comme point de départ.

Dans les débats publics, « l’effet d’ancrage » donne une prime aux personnes qui ont la capacité de prise de parole publique (expert, militant, journaliste, contestataire contre les institutions…), plus encore si leur point de vue est argumenté et que ceux qui les écoutent n’ont qu’une vague opinion sur le sujet.

Ce comportement revient à sous-estimer la probabilité d’une catastrophe, ses effets sur sa propre existence et son potentiel destructeur.

À cause du biais de normalité, de nombreuses personnes ne se préparent pas suffisamment à une catastrophe naturelle, un effondrement financier ou des crises issues d’une erreur humaine.

Il est rapporté qu’environ 70% des gens affichent un biais de normalité au cours d’une catastrophe.

Le biais de normalité peut surgir en réponse à des avertissements en amont d’une catastrophe ou face à une catastrophe avérée, comme un effondrement financier, des accidents de la route, des catastrophes naturelles ou une guerre.

Le biais de normalité est aussi appelé « paralysie des facultés d’analyse » (analysis paralysis) ou « faire l’autruche » (the ostrich effect) et certains secouristes parlent de « panique négative » (the negative panic).

Le comportement opposé au biais de normalité est la réaction excessive (surréaction), ou biais du scénario du pire (worst-case scenario bias), qui consiste à voir de légères variations par rapport à la routine comme les indices d’une catastrophe imminente.

Plus d’infos : wikipedia

C’est une interprétation et une perception sélective d’informations allant dans le sens d’une première impression (« il ne voit que ce qu’il veut bien voir »).

Il a été mis en évidence de manière empirique par Edward Thorndike en 1920 et démontré par Solomon Asch en 1946.

Une caractéristique jugée positive à propos d’une personne ou d’une collectivité a tendance à rendre plus positives les autres caractéristiques de cette personne, même sans les connaître (et inversement pour une caractéristique négative).

L’effet de halo est défini en psychologie comme une distorsion de la perception (ou un biais cognitif) qui affecte la manière dont les gens interprètent les informations concernant une personne avec laquelle ils se sont formés une impression positive globale.

Si on prend l’exemple d’une personne qui apprend que quelqu’un à propos de laquelle elle s’est formée une impression positive a triché sur ses impôts.

En raison de la cette impression globale positive, la personne aura tendance à ignorer ou à minimiser la signification de cette nouvelle information qui contredit son impression globale déjà constituée.

Elle peut même en arriver à penser que la personne a simplement fait une erreur, ce qui dispense d’une remise en cause de l’impression globale.

L’effet de halo fait référence à la tendance que nous avons à évaluer un individu à de façon positive pour de nombreux traits en raison d’une croyance commune.

Bresson distingue l’effet de halo affectif (juger positivement sur d’autres traits quelqu’un qu’on trouve sympathique) et l’effet de halo cognitif (juger positivement sur différents paramètres quelqu’un dont on nous a dit du bien par ailleurs.

Plus d’infos : wikipedia

Le terme désigne également la tension qu’une personne ressent lorsqu’un comportement entre en contradiction avec ses idées ou croyances.

Ce concept a été formulé pour la première fois par le psychologue Leon Festinger dans son ouvrage A theory of cognitive dissonance (1957).

Festinger étudie les stratégies de réduction de la tension psychologique induite et le maintien de la cohérence personnelle, y compris les stratégies d’évitement des circonstances identifiées comme source de dissonance.

Plus d’infos : wikipedia

Dans une de ses expériences principales, il démontre que lorsqu’on demande aux sujets de supprimer volontairement un stéréotype ou une pensée (« thought suppression »), ce stéréotype ou cette pensée revient en force plus tard, lorsqu’on cesse de le supprimer.

Expérience

On présente la photo d’un skinhead et on demande à tous les sujets de décrire la vie quotidienne de cette personne.

À la moitié des sujets (G1), on demande de faire attention à ne pas donner de réponses stéréotypées, tandis que l’autre moitié (G2) ne reçoit pas cette consigne de suppression.

Dans un deuxième temps, on montre aux sujets la photo d’un autre skinhead.

Cette fois, on demande simplement à tous les sujets de décrire la vie quotidienne de cette personne (pas de consigne d’inhibition).

Les résultats montrent que dans la description du premier skinhead, conformément à la consigne, le groupe G1 donne des réponses moins stéréotypées que le groupe contrôle (G2).

Cependant, lors de la description du deuxième skinhead, les sujets qui auparavant avaient eu la consigne de suppression (G1) décrivaient la vie quotidienne de ce nouveau skinhead de manière beaucoup plus stéréotypée que le groupe G2 (dont la description n’a que peu varié par rapport à celle du premier skinhead).

Interprétation des résultats

Les résultats de cette expérience s’expliquent assez simplement en termes d’amorçage.

En effet, pour pouvoir inhiber correctement un stéréotype, il faut le définir précisément afin de ne pas commettre d’erreurs.

Par conséquent, les sujets G1 ont davantage activé le stéréotype qui est devenu « hyperaccessible », et lorsqu’ils n’ont plus à l’inhiber, le stéréotype réapparaît amplifié.

Cela est dû à la sous-estimation systématique par l’esprit humain de la variabilité des données.

Exemples

Thomas Gilovich a constaté que la plupart des gens pensent que la séquence suivante n’est pas aléatoire :

OXXXOXXXOXXOOOXOOXXOO

Or, cette séquence a plusieurs caractéristiques d’un échantillon aléatoire :

- il y a quasiment le même nombre de O et de X

- dans la séquence, il y a autant de cas (10) où le caractère est identique au précédent que de cas où le caractère est différent du précédent.

Dans de telles séquences, l’esprit s’attend à trouver davantage de combinaisons différentes que ne le prévoit l’analyse statistique.

La probabilité qu’un caractère tiré soit différent du précédent est évidemment de 0,5 alors que l’esprit humain s’attend à une probabilité plus forte, de l’ordre de 0,73 : si l’on tire deux fois de suite à pile ou face (P/F), on a autant de chances d’obtenir le même résultat deux fois (PP, FF) que deux résultats différents (PF, FP) ; mais il semble que nous trouvions les résultats différents plus « normaux ».

De même, il semble anormal à la plupart des gens qu’une pièce tombe quatre fois sur face de suite lors d’une série de lancers.

Pourtant dans une série de 20 lancers, il y a une chance sur deux d’obtenir quatre face de suite.

L’erreur commise est dite erreur du parieur.

Ce qui serait rare, inattendu et improbable avec le simple hasard serait de lancer une pièce vingt fois et que le résultat soit à chaque fois l’inverse du précédent.

Dans une série de tels lancers, il est plus improbable que probable que des séries de lancers courtes de 2, 4, 6, 8, etc., donneront un résultat que nous savons prévisible logiquement par les lois du hasard.

Sur le long terme, des lancers de pièces donneront 50 % de face et 50 % de pile (en supposant un lancer correct et une pièce correcte).

Mais sur un court terme, une large gamme de probabilités peuvent se réaliser, y compris certaines séries qui paraissent hautement improbables.

Explications

Daniel Kahneman et Amos Tversky ont expliqué ce genre de prédiction comme étant causé par l’heuristique de la non-représentativité (c’est-à-dire la tendance à établir des liens entre des éléments semblables, ou entre un élément et un surensemble auquel il semble appartenir).

Gilovich affirme que de semblables perceptions sont observées dans des séries à deux dimensions, telles que trouver des regroupements des lieux d’impact des V-1 à Londres pendant la Seconde Guerre mondiale, ou à trouver des séries dans les fluctuations des cours de la bourse.

L’illusion des séries a fait l’objet d’une étude de Gilovich, Robert Vallone et Amos Tversky.

Ils ont montré que l’idée selon laquelle des joueurs de basket-ball réussissent (ou manquent) des séries de tirs (on dit que le joueur a « la main chaude » ou bien est « en déveine ») est erronée.

es analyses ont été réalisées sur les joueurs des 76ers de Philadelphie pendant la saison 1980-81 et sur les lancers francs des Celtics de Boston sur deux saisons.

Elles n’ont pas montré que les joueurs réussissaient des séries de tirs réussis ou de tirs ratés plus que le hasard ne le laisse présager.

Quand un joueur réussit son premier lancer, il réussit le second 75 % du temps.

Mais lorsqu’il rate le premier lancer, il réussit le second également 75 % du temps.

C’est l’illusion des séries qui a fait que le MI-5 britannique a mené une enquête serrée auprès du journal The Daily Telegraph.

En effet, dans les jours précédant immédiatement le débarquement du 6 juin 1944, ce journal a sorti des grilles de mots croisés qui reprenaient plusieurs noms de code ultra-confidentiels des diverses opérations du débarquement : opération Utah (le 2 mai 1944), opération Omaha (le 22 mai 1944), opération Mulberry (le 30 mai 1944), opération Overlord (le 2 juin 1944) et opération Neptune (le 2 juin 1944).

En fait, c’était une coïncidence.

L’illusion des séries fait la fortune des sociétés de jeux de hasard.

En effet, la plupart des gens refuseraient de jouer une combinaison qui soit une série telle que 1-2-3-4.

Ils croient qu’en jouant une combinaison qui semble aléatoire telle que 5-19-23-37, ils ont beaucoup plus de chance de gagner, alors que ces deux combinaisons ont la même probabilité de sortir.

De la même façon, certaines personnes suivent des statistiques sur la fréquence de sortie des divers nombres dans les tirages passés, et jouent les nombres « en retard » dans ces fréquences de tirage avec le raisonnement que ces nombres vont sortir à terme, puisque tous les nombres ont la même probabilité de sortir.

Le raisonnement est faux, c’est l’erreur du parieur.

Si l’on mélange l’illusion des séries avec le biais de confirmation (c’est-à-dire la tendance d’une personne à préférer les éléments qui confirment plutôt que ceux qui infirment une hypothèse), on obtient une recette pour l’aveuglement et l’illusion.

La distinction avec les autres coûts est importante pour les scénarios où l’on envisage, ou bien où l’on craint de subir, de renoncer à, ou de ne plus être en mesure d’utiliser ce qu’ils ont servi à acquérir.

« The Concorde fallacy » ou « l’erreur de jugement du Concorde » fait référence à l’entêtement des gouvernements français et britannique à poursuivre ce projet, pour des raisons politiques et de prestige mais aussi parce que des dépenses considérables avaient été engagées, alors que le fait que l’exploitation commerciale du Concorde ne pouvait être rentable était admis depuis 1973, une combinaison de facteurs causant l’annulation de presque toutes les commandes en option. Parmi ces facteurs, le premier choc pétrolier, les difficultés financières des compagnies aériennes, l’absence de soutien du projet en Amérique du Nord, ou encore l’accident au salon du Bourget du concurrent direct soviétique, le Tupolev Tu-144

Irrationalité dans leur prise en compte

Pour un agent rationnel, ces coûts ne devraient pas peser dans la balance pour les choix qui sont réalisés après qu’ils ont été engagés.

En pratique cependant, ils interviennent souvent dans le raisonnement, du fait de l’aversion pour la perte.

On désigne en anglais ce biais par le terme de sunk cost fallacy.

Par exemple, un spectateur dans une salle de cinéma qui trouve le film très mauvais et s’ennuie hésitera souvent à quitter la salle avant la fin du film, pour ne pas gâcher l’argent qu’il a dépensé pour son billet.

Mais si un ami lui a donné un billet gratuitement parce qu’il ne pouvait pas se rendre à la séance, le même spectateur n’hésitera alors généralement pas à partir.

Pour un agent parfaitement rationnel, les deux décisions sont pourtant exactement équivalentes, puisque le coût financier de quitter la salle est nul dans les deux cas, et l’intérêt du temps qu’il va passer à l’extérieur par rapport à celui passé à regarder le film jusqu’à la fin est lui aussi le même.

Si cette croyance comporte un risque ou entraîne une erreur, on parle alors d’optimisme irréaliste.

Un certain nombre de recherches ont mis en évidence une tendance chez l’être humain à plutôt s’attendre à des événements positifs qu’à des événements négatifs.

Ce biais d’optimisme serait assez commun et ne dépendrait pas nécessairement du sexe, de l’âge, de l’origine ou de la culture.

Des biais optimistes sont aussi rapportés chez des animaux tels que les rats et les oiseaux.

Il existe quatre facteurs qui induisent une tendance optimiste chez une personne : l’état final souhaité, ses mécanismes cognitifs, les informations que la personne a sur elle-même comparées à celles qu’elle a sur les autres et enfin son humeur générale.

Le biais d’optimiste apparaît dans un certain nombre de situations.

Par exemple : des personnes qui s’attendent à vivre plus longtemps que la moyenne ou sous-estiment les risques de divorce les concernant, des fumeurs qui estiment qu’ils sont moins susceptibles de contracter un cancer du poumon ou une maladie pulmonaire que les autres fumeurs, ou des commerçants qui pensent qu’ils sont moins exposés à des pertes sur les marchés.

Le biais d’optimisme se produit aussi bien à propos d’événements positifs (comme penser avoir une meilleure réussite financière qu’autrui) que d’événements négatifs (comme étant moins probable d’avoir un problème d’alcool).

Toutefois les recherches suggèrent que le biais est plus fort pour des événements négatifs (effet de valence).

Des conséquences différentes résultent de ces deux types d’événements : les événements positifs entraînent souvent des sentiments de bien-être et d’estime de soi, alors que les événements négatifs ont pour conséquence d’augmenter les comportements à risque ou l’absence de précautions en matière de sécurité.

Plus d’infos : wikipedia

https://www.youtube.com/watch?v=B_rStLPDn3c

- Sangu Mandanna – La société très secrète des sorcières extraordinaires - 15/01/2026

- Bonne et Heureuse année 2026 à vous + Récap’ des sujets postés sur le blog en 2025 - 12/01/2026

- Evil Eater - 10/01/2026

![[Philosophie] Rasoir d'Ockham](https://www.geek-otaku-news.com/wp-content/uploads/2020/09/rasoir-390x205.jpg)